铰接类物体在人类生活中随处可见。目前,研究人员通常在单例情况下固定运动力学结构来研究就各类别级位姿估计(CAPE)法。

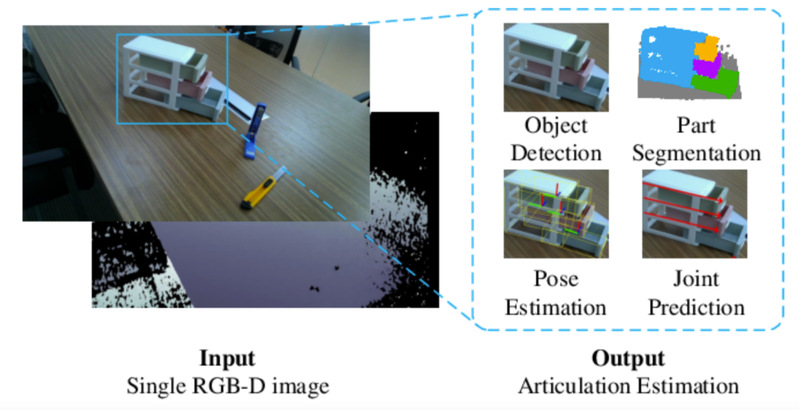

考虑到这些限制,卢策吾教授研究组(上海交通大学计算机科学与工程系特别研究员、浙江大学上海高等研究院计算+AI双聘教授)试图在单一RGB-D图像下估计运动力学结构未知的六维多铰接物体在组件层面的位姿,并将其转换到现实环境下,提出CAPE-Real(CAPER)任务设置。这种设置允许在同一语义类别内存在多种运动学结构,并且在真实世界的观察中实现多个实例并存。

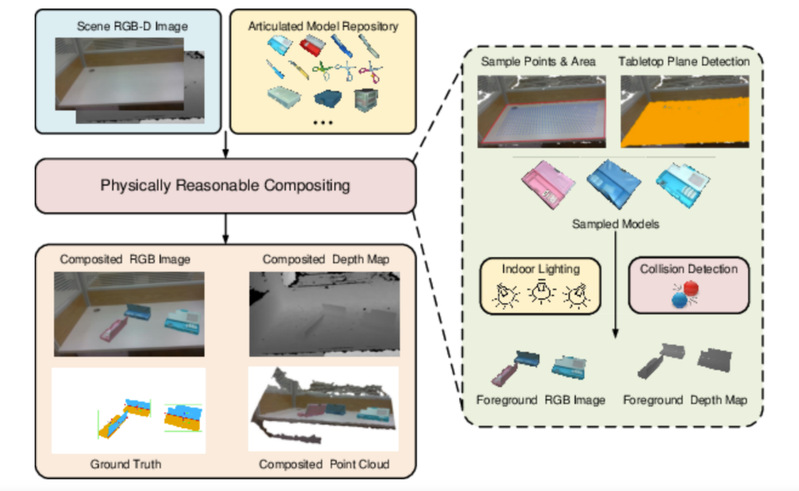

为了支持这项任务,他们建立了一个铰接模型库ReArt-48,并提出了包含快速铰接对象建模(FAOM)和半真实的混合现实技术(SAMERT)的高效数据集生成管道。

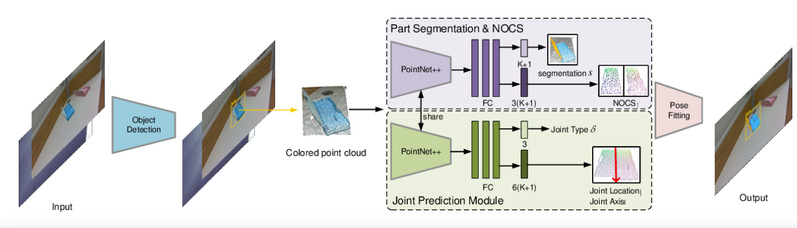

立管道的同时,作者们还建立了一个大规模的混合现实数据集ReArtMix和一个真实世界数据集ReArtVal。为解决CAPER问题和数据集问题,他们提出了一个有效的框架,在单前馈下利用RGB-D输入来估计多个实例在组件水平的位姿。作者们从RGB-D输入中引入物体检测来处理多实例问题,并将每个实例分割成若干组件。为了解决运动学结构未知的问题,他们采用铰接解析网络(Articulation Parsing Network)模块来按组件分析其六维位姿,以及铰接部分的性质。大量实验表明,该方法在估计CAPER、CAPE和现实机械臂位姿上表现出色,可为未来CAPER任务研究提供强有力的基准。

该工作发表于IEEE Transactions on Image Processing,文章链接在:Toward Real-World Category-Level Articulation Pose Estimation | IEEE Journals & Magazine | IEEE Xplore。代码将随后公开。

今日编辑:徐敏